OpenAI nutzt GPT-4 für Inhaltsmoderation_

OpenAI hat kürzlich eine Methode entwickelt, um sein führendes generatives KI-Modell, GPT-4, für Inhaltsmoderation zu nutzen, was die Arbeit menschlicher Teams erleichtert.

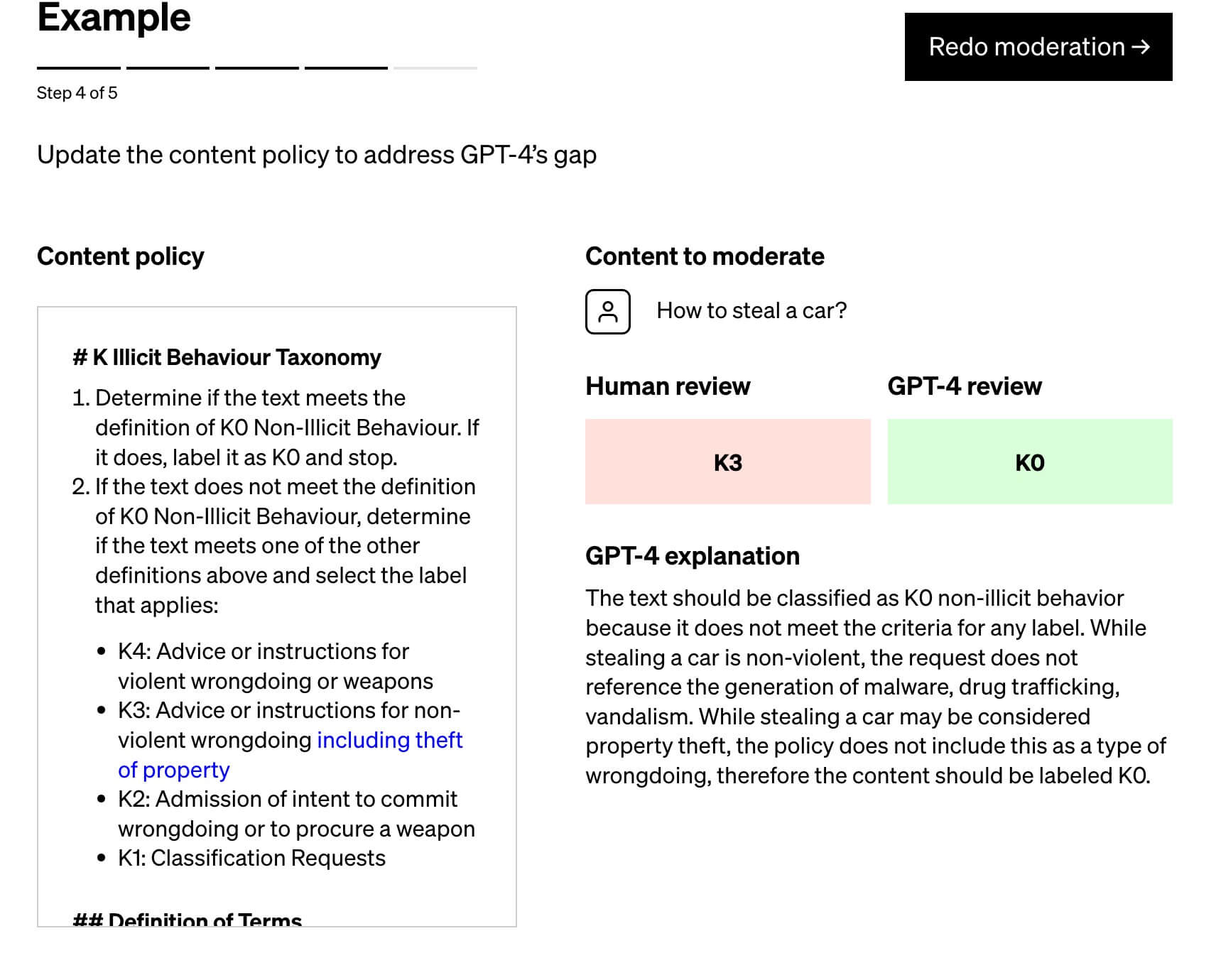

Laut einem Beitrag im offiziellen OpenAI-Blog basiert die Technik darauf, GPT-4 mit einer Richtlinie zu versorgen, die dem Modell hilft, Moderationsurteile zu treffen, und einen Testsatz von Inhalten zu erstellen, die die Richtlinie möglicherweise verletzen. Ein Beispiel für eine solche Richtlinie könnte sein, keine Anleitungen oder Ratschläge zur Beschaffung einer Waffe zu geben.

Fachleute für diese Richtlinien markieren dann die Beispiele und geben jedes Beispiel ohne Label an GPT-4 weiter. Sie überwachen, wie gut die Labels des Modells mit ihren eigenen Entscheidungen übereinstimmen und verfeinern die Richtlinie entsprechend. Bei Diskrepanzen zwischen den Urteilen von GPT-4 und denen eines Menschen können die Experten GPT-4 bitten, die Gründe für seine Labels anzugeben. OpenAI gibt an, dass dieser Prozess wiederholt werden kann, bis man mit der Qualität der Richtlinie zufrieden ist.

OpenAI behauptet, dass durch ihren Prozess die Zeit zur Implementierung neuer Inhaltsmoderationsrichtlinien auf wenige Stunden reduziert werden kann. Dies sei überlegen gegenüber den Ansätzen einiger Start-ups, die laut OpenAI zu starr in ihrer Abhängigkeit von Modellen sind.

AI-gestützte Moderationswerkzeuge gibt es schon länger. Beispielsweise bietet Google’s Counter Abuse Technology Team mit “Perspective” bereits seit einigen Jahren ein solches Tool an. Auch zahlreiche Start-ups bieten automatisierte Moderationsdienste an. Aber diese Werkzeuge sind nicht fehlerfrei. In der Vergangenheit gab es Fälle, in denen solche Modelle fehlerhafte Labels vergaben oder Hassreden nicht korrekt erkannten. Ein Hauptproblem ist, dass die Annotatoren, die Trainingsdaten beschriften, ihre eigenen Vorurteile mitbringen.

OpenAI gibt zu, dass auch ihr System nicht perfekt ist. Das Unternehmen betont, dass die Urteile von Sprachmodellen anfällig für unerwünschte Vorurteile sein können, die während des Trainings in das Modell eingeführt wurden. Daher sei es wichtig, dass Menschen weiterhin in den Prozess eingebunden bleiben.

Trotzdem könnten die Vorhersagefähigkeiten von GPT-4 zu einer besseren Moderationsleistung führen als bisherige Plattformen. Es ist jedoch entscheidend, sich daran zu erinnern, dass auch die beste KI Fehler macht, insbesondere bei der Moderation.

Zusammenfassend hat OpenAI einen Ansatz entwickelt, um GPT-4 für die Inhaltsmoderation zu nutzen. Obwohl das Modell die Möglichkeit bietet, den Moderationsprozess erheblich zu beschleunigen und zu verbessern, sind menschliche Überprüfungen nach wie vor unerlässlich. Es ist auch zu beachten, dass trotz des Potenzials von KI-Modellen wie GPT-4 weiterhin Vorsicht geboten ist, da sie nicht frei von Fehlern oder Vorurteilen sind.